大语言模型核心

大语言模型核心

jwangGPT

人工智能研究实验室OpenAI在2022年11月30日发布的全新聊天机器人ChatGPT,背后的GPT模型就是基于Transformer架构

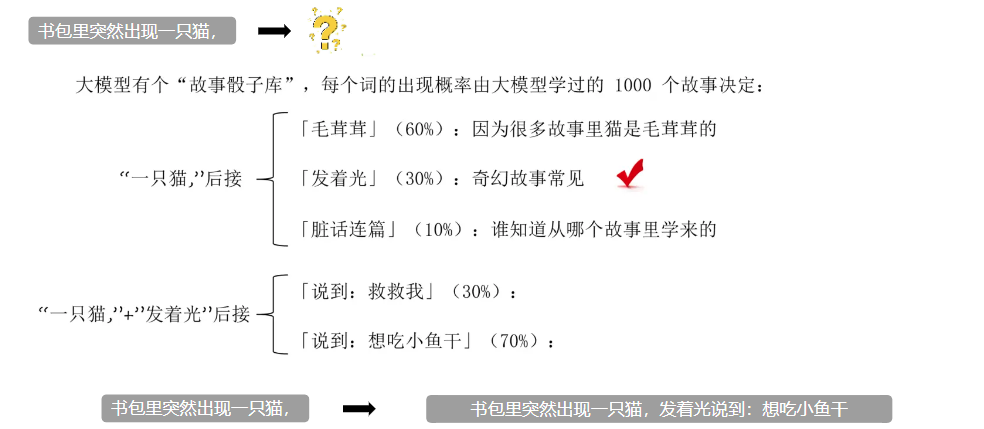

生成式

意味着模型能够生成文本根据给定的起始词或句子,预测文字出现的先后概率,生成一段连续的文本,最终形成输出

神经网络

全称为人工神经网络(Artificial Neural Network, ANN),是一种受生物神经系统启发而设计的计算模型。它由大量相互连接的节点(或称神经元)组成,旨在模仿人类大脑处理信息的方式

- 卷积神经网络(Convolutional Neural Network, CNN):特别适合处理具有网格结构的数据,如图像,广泛应用于计算机视觉领域。

- 循环神经网络(Recurrent Neural Network, RNN):用于处理序列数据,能够记住过去的信息并将其应用于当前的处理过程中。但是处理的序列不能太长,否则会有遗忘。

- 长短时记忆网络(Long Short-Term Memory),是一种特殊的循环神经网络(RNN)。LSTM是RNN的改进版本,能更好地捕捉长距离依赖关系,比如语言、视频、股票价格等需要联系上下文的信息。其核心能力:记住重要的,忘记不重要的。

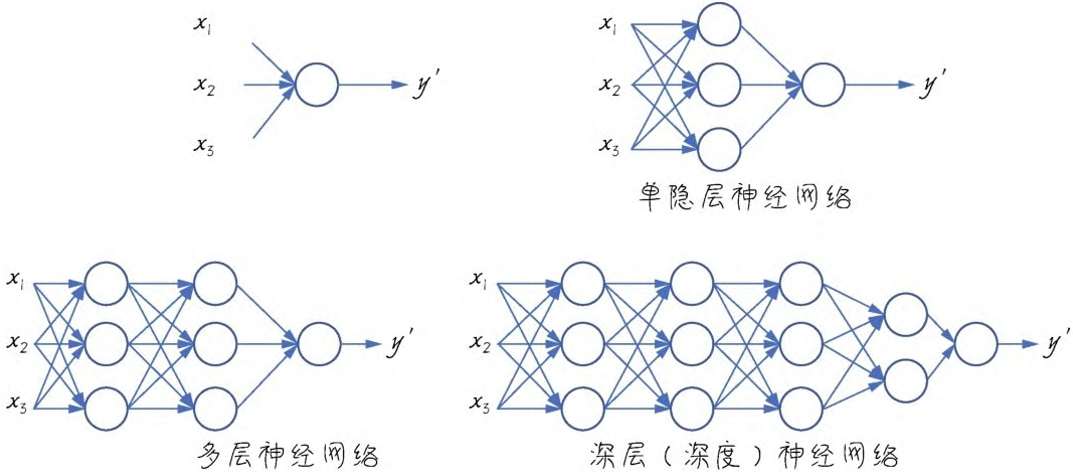

Transformer架构就属于深度学习/深度神经网络的一种

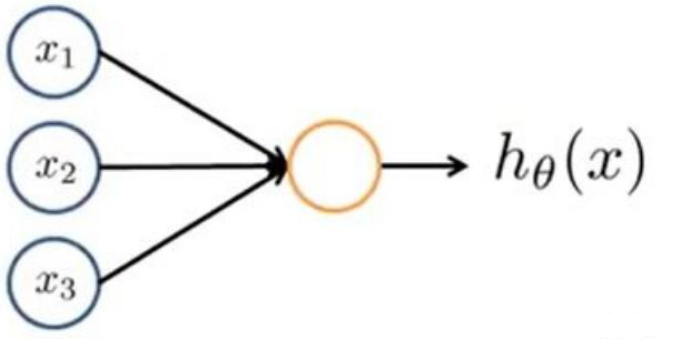

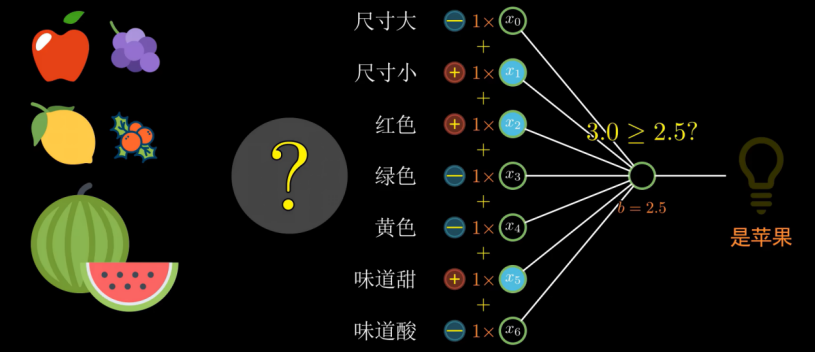

感知机-神经网络的基本单元

神经网络中的基础组件(不严谨,但是可以这么理解)叫“感知机”,可以简单把它理解为一个函数,接收输入,产生输出。输出可以被限定为只能是 0 或 1,也可以限定为是0~1之间的一个数

深度学习

从单个感知机发展到多个感知机组成可以组成单层神经网络,再继续发展,层数目超过一个,就逐渐由“浅”入“深”,进入深度学习/深度神经网络学习的领域。

当然,所谓“深”,只是相对而言的。相较于单层,十几层的层的神经网络也可以称得“深”。而大型的深度神经网络经常达到成百上千层,则十几层的网络也显得很“浅”