prompt-产品化开发

prompt-产品化开发

jwang与提示词智能体不同,产品化开发需要考虑更多:

如何稳定的获取网页内容?

如何选择适合的 AI 大模型 API 服务?

面向大模型 API ,如何构建生产级提示词?

如何稳定的获取网页内容?

- 获取网页内容极大依赖于大模型对话产品的外链解析能力。然而,这种方式非常容易遭到平台反爬机制的制裁。在实验过程中,最影响提示词方案效果的因素,不是大模型的生成质量,而是无法稳定地捕获网页内容。

- 转换思路来看,网页内容通常以明文形式展示在用户浏览器中,内容平台不可能对用户设备进行反爬制裁。通过用户浏览器,以浏览器插件形式本地提取网页内容,正是一种稳定、经济的解决方案。

开发时,如何确定需要插件获取哪些网页元素?

你可以拿着初版提示词,询问 AI :

我希望通过浏览器插件,获取提示词中所需的标签页标题、链接、内容元素,请你帮我设计获取相关元素的 js 代码

如何选择适合的 AI 大模型 API 服务?

纯靠词生卡 Prompt 完成卡片样式输出,固然是非常灵活的 AI 智能体方案。

但倘若在最终落地产品中,还是每次都依赖大模型重新生成卡片的样式代码,反而会消耗大量的输出 token,耗时且不经济。

此外,在实际使用中,用户通常只固定使用一到两个常用模板,对自定义样式的需求并不频繁。

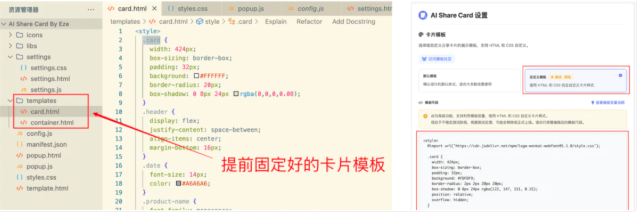

所以在开发 AI Share Card 插件的过程中,我选择将模板生成功能设计为固定的代码组件,而让大模型专注于内容总结的功能。

如果用户需要选择其他模板,则通过增加更多模板选项 or 自定义模板代码功能实现

如此一来,对 AI 大模型的要求就不会动辄需要像 Claude 3.5 sonnet 那样高不可攀的顶级模型。

处理纯文本总结任务,仅需 13B 或更小参数的模型,加上精调的提示词,就能产生很好的结果。

一旦明确模型的任务,AI API 服务的选型要求就清晰了:

较长的上下文窗口:内容总结类任务需要较大的上下文长度;

响应速度要快、并发支持要高:以便在多人使用插件时,保持良好的性能表现;

免费或尽量低价:减少模型 token 费用。

面向大模型 API ,如何构建生产级提示词?

与大模型对话产品的提示词不同。

对于大模型 API,我们需要利用插件预先获取的网页内容变量、提示词和 API 请求参数,拼搭出完整的 API 提示请求,精确引导 API 返回我们想要的生成结果。

根据 BigModel 官网给出的请求示例,可以看到需要在请求中传递Model类型、系统提示词、用户提示词、top_p、temperature等关键参数。

因此,可以构建相应的 API 请求内容如下:

- 设定系统提示词,定义基础任务:

# 网页分享卡片生成 |

- 设定用户提示词,提供具体任务数据,并要求大模型按 JSON 格式返回生成结果

注:为确保大模型能有效进行内容总结,提示词中使用 ${} 语法动态引用插件获取的网页数据(如标题、描述、正文等)。在实际发送 API 请求时,这些变量会被替换为真实的网页内容

请分析以下网页内容,生成一个结构化的分享卡片数据: |

- 最后,根据文本总结类任务的通常经验与实际调试情况,设定其他 API 所需关键参数

如果你缺少参数设定的经验,也可以先询问 AI 文本总结类的模型 API 请求,temperature 设定多少合适,再逐步调试效果即可。